“Seamos claros, esta tecnología se limita a detectar material de abuso sexual infantil almacenado en iCloud y no accederemos a la solicitud de ningún gobierno para expandirlo”. Apple debió defender sus iniciativas en contra de la pornografía infantil luego de las críticas de personalidades como Edward Snowden, el CEO de WhatsApp y la Electronic Frontier Foundation (EFF), entre otras. ¿Por qué? Todos coinciden en que las herramientas de Apple atentan contra la privacidad y que pueden ser utilizadas para espiar a las personas.

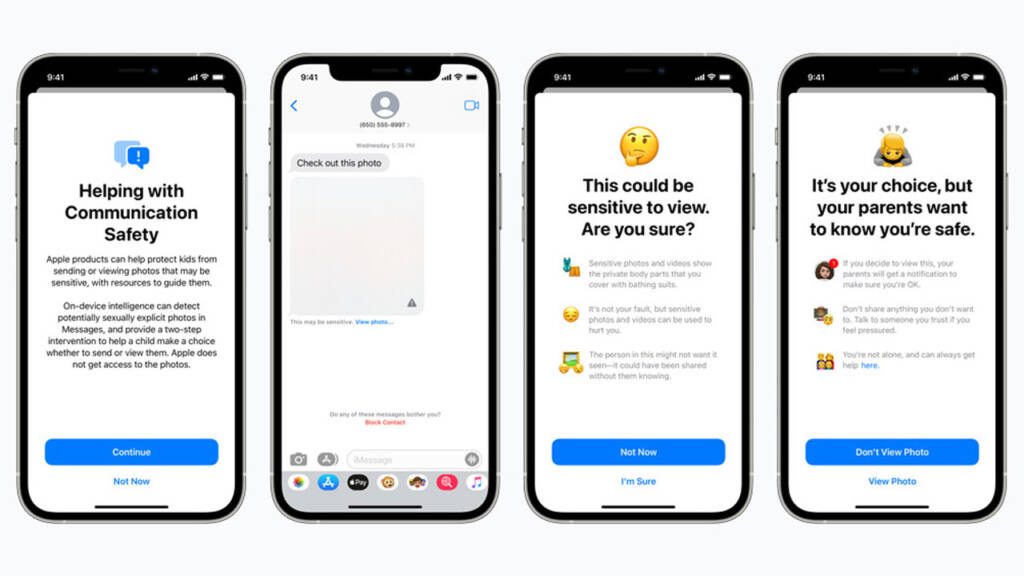

Apple anunció la semana pasada tres herramientas para detectar contenidos vinculados con abuso sexual infantil. La posibilidad de escanear las imágenes almacenadas en iCloud es la más criticada: si bien Apple no “ve” las fotos, solo compara una especie de “huella digital” con una base de datos para detectar fotos prohibidas, la herramienta encargada de hacerlo será incluida a nivel del sistema operativo, es decir, en el iPhone, iPad o Mac y no en la nube.

Si bien Apple asegura que el escaneo de las fotos ocurrirá solo si las personas suben contenidos a iCloud Fotos, no queda claro porqué el sistema de detección no trabaja solo en la nube y es instalado en el sistema operativo.

Esa es la manera en que trabajan los servicios de Google, Microsoft y Dropbox, por solo mencionar algunos.

Algo similar ocurrirá con Mensajes, que también podrá detectar imágenes de abuso sexual infantil y reportarlas.

Apple asegura que preservará la privacidad de los usuarios, pero el poder de la herramienta y sus posibles usos futuros despiertan inquietudes. Por ejemplo, un gobierno podría reclamar que Apple identifique actividades prohibidas e incluso rostros.

La propia Apple podría utilizar la herramienta con otros fines. “Todo lo que se necesitaría para ampliar la estrecha puerta trasera que Apple está construyendo es una expansión de los parámetros de aprendizaje automático para buscar tipos adicionales de contenido, o un ajuste de los indicadores de configuración para escanear, no solo las cuentas de los niños, sino de cualquier persona”, escribieron desde la EEF.

Voces

“Apple planea crear una puerta trasera en sus sistemas de almacenamiento y mensajería”, escribieron desde la EEF, donde agregaron que “es imposible crear un sistema de escaneo local que pueda ser usado únicamente para imágenes explícitas enviadas o recibidas por niños. Como consecuencia, incluso un esfuerzo bien intencionado para construir un sistema de este tipo romperá las promesas clave del cifrado del mensajero y abrirá la puerta a abusos más amplios”.

Will Cathcart, líder de Whatsapp, escribió un hilo en Twitter para mostrar su preocupación: “Creo que este es un enfoque equivocado y un revés para la privacidad de las personas en todo el mundo. La gente preguntó si adoptaremos este sistema para WhatsApp. La respuesta es no”.

Edward Snowden, ex empleado de la CIA y la NSA reconocido por divulgar la existencia del programa de vigilancia masiva clandestino PRISM, fue contundente: “No importa qué tan bien intencionado sea, Apple está poniendo en marcha un sistema masivo de vigilancia en todo el mundo. No se confundan: si hoy pueden escanear pornografía infantil, mañana pueden escanear en busca de cualquier cosa”.

Del otro lado, David Forsyth, presidente del departamento de Ciencias de la Computación de la Universidad de Illinois, se mostró a favor: “El enfoque de Apple preserva la privacidad mejor que cualquier otro que yo conozca. La precisión del sistema de coincidencia, combinada con el umbral, hace que sea muy poco probable que se revelen imágenes que no sean imágenes conocidas de abuso infantil”.

John Clark, presidente del NCMEC, también apoyó la idea: “La protección ampliada de Apple para los niños cambia las reglas del juego. La realidad es que la privacidad y la protección infantil pueden coexistir”.